こんにちは!まーです。

今日は、僕が3Dプリンターで「世界に一つだけの最高傑作」を作ろうとして、見事に失敗した話をします。何を作ろうとしたかって? 自分の顔ですよ、自分の顔 😅

この記事の内容はYouTube動画やPodcastでも解説しています。

リビングに現れた「呪物」

3Dプリンターを手に入れて、最初に思ったんです。

「せっかくだから、世界に一つしかない最高のものを作りたい」

で、世界に一つしかないものって何だろう?と考えた結果、たどり着いた答えが「自分の顔」だったんですよね。

最新のiPhoneにはLiDARセンサーがついてる。Polycamっていう無料の3Dスキャンアプリもある。これを組み合わせれば、自分の精巧なフィギュアが作れるはずだ!

…そう思っていた時期が僕にもありました。

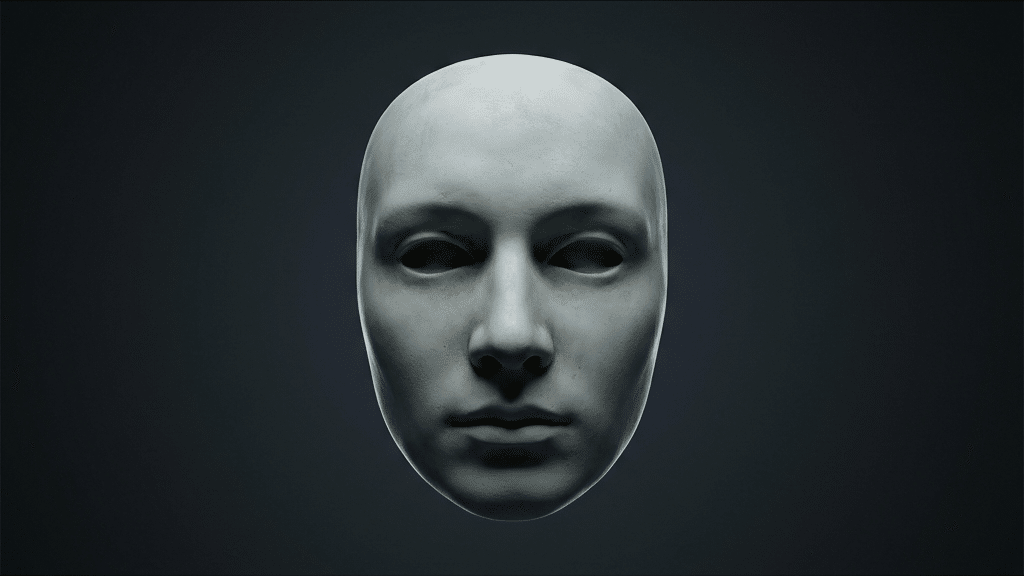

結果から言うと、出力されたのは「デスマスク」でした。

リビングのテーブルに置いた瞬間、妻と子供が無言になったんです。「…これ、なに?」という目で見られて、僕も正直、自分で作ったものなのに直視できなかった 💀

なぜこんなことになったのか。検証していきます。

※先に言い訳しておきますが、スキャン結果はアプリの処理・距離・照明・被写体の動き・端末温度などで大きく変わります。本記事は「僕の環境で起きた現象」をベースにした、いち個人の体験談です!

スマホ3台スキャン戦争

一度失敗したからといって諦める僕ではありません。家族の端末を総動員して、どのスマホが一番マシな顔をスキャンできるか試してみました。

iPhone 15 Pro(パパの端末)

LiDARセンサー搭載ということで、一番期待していた端末です。

PolycamのLiDARモードを使うと、確かにスキャンは爆速。10秒くらいで顔の形が取れるんですよね。「おお、すごい!」と思ったのも束の間…

出来上がったモデルを見て愕然としました。目も鼻も口も、全部溶けてるんです。のっぺらぼうとまでは言わないけど、「熱で溶けかけた蝋人形」みたいな顔になってる 😱

これ、LiDARの精度はざっくり 「cm級」 になりやすいと言われているのが原因かもしれません。部屋の間取りなら十分なんですが、顔の凹凸みたいな 「mm単位の情報」 を拾うには、少し解像度が不足しやすいんですよね。

Galaxy S25(ママの端末)

じゃあLiDARじゃなくて、カメラで撮影するPhotoモードならどうだ?ということで、妻のGalaxy(Snapdragon 8 Elite for Galaxy搭載)を借りました。

最新チップなので処理能力は十分…のはずだったんですが、撮影中にスマホが かなり熱く なりました(温度は測っていませんが、思わず手を離したくなるレベル💦)。

そしたら案の定、高負荷で不安定になったのか、アプリが落ちたりトラッキングがズレたり…。再起動して確認したら、左頬が鼻の上に来るという異形化バグが発生していました。

やっぱりフォトグラメトリって重い処理なんですね 😅

Pixel 9a(子供の端末)

最後の希望、Pixel 9a。LiDARはないけど、Googleの画像処理技術なら何とかしてくれるんじゃないか?

結果、一番きれいに撮れた…と思いきや、よく見ると顔に知らないシワや穴が生成されてるんです。

これ、肌みたいに 特徴点が少ない(のっぺりした)部分 だと、再構成が不安定になってノイズが出やすいのかもしれません。AIが「たぶんここに何かあるはず」と頑張りすぎたのか、10歳くらい老けた顔になりました 🤔

なぜ「不気味」なのか?

ここからちょっと技術的な話になります。でも、これを知っておくと「なぜ失敗したか」が分かるので、次に活かせるんですよね。

中空の罠と「ホローフェイス錯視」

3Dスキャンのモデルって、多くの場合 「表面だけのメッシュ(薄い殻)」 になりやすいんです。

実はPolycamの無料版はエクスポート形式が限られることが多く(※僕の環境ではglTFでした)、これをBlenderなどで無理やりSTLに変換して印刷したんですが、中身が詰まっていない「お面」の状態だったんですよね。

これをそのまま印刷すると、裏から見たときに 「ホローフェイス錯視」 という現象が起きやすくなります。

人間の脳って、凹んだ顔を見ても「凸の顔」として認識しようとするんですよね。結果、どこから見ても目が合うように感じてゾワっとする。リビングで家族が凍りついた原因、たぶんこれです 💀

髪と目はスキャナーの苦手分野

髪の毛や目は、「細かい形状 + 反射/透明感」 が絡むので、スマホスキャンだと乱れやすい傾向があります。

僕の場合、黒髪がノイズとして処理されて頭から棘が生えたり、目の部分がうまく認識されずに穴が開いたりしました。これが不気味さを加速させるんですよね…。

色の喪失がもたらすデスマスク感

画面上ではカラフルで生き生きしたモデルに見えても、それを白いPLAフィラメントで出力すると…

死蝋化した遺体みたいになるんです。

単色の白やグレーって、質感が蝋人形とか石膏像に近いんですよね。しかも目を閉じた状態でスキャンしてると、余計に死体っぽく見える。

さらにフィラメントが薄いと、内部のインフィル(格子模様)が透けて見えることがあって、これがまた「人体改造」っぽくて怖いんです 😅

愛される顔にするために

じゃあどうすればいいのか? 失敗から学んだ対策をまとめます。

撮影のコツ

① LiDARモードは避けて、Photoモード を選ぶ(手間はかかるけど解像度は高い!)

② 照明を固定する(自然光が変わると色ムラになる)

③ できるだけ動かない(呼吸で揺れるだけでも肌が荒れる)

④ 髪は帽子で隠すか、後ろで束ねる

データの修正

Meshmixerという無料ソフトの 「Make Solid(ソリッド化)」 機能を使うのがおすすめです。

① 穴や薄殻になっているメッシュを「印刷向けの一体形状」に再生成する

② 首の下に台座をつけて「胸像」っぽくする

③ 表面のスパイクやノイズを滑らかにする

こうすると「自分の顔のフィギュア」から「自分をモデルにした彫刻作品」にレベルアップするんですよね。芸術に昇華させるという発想です 💡

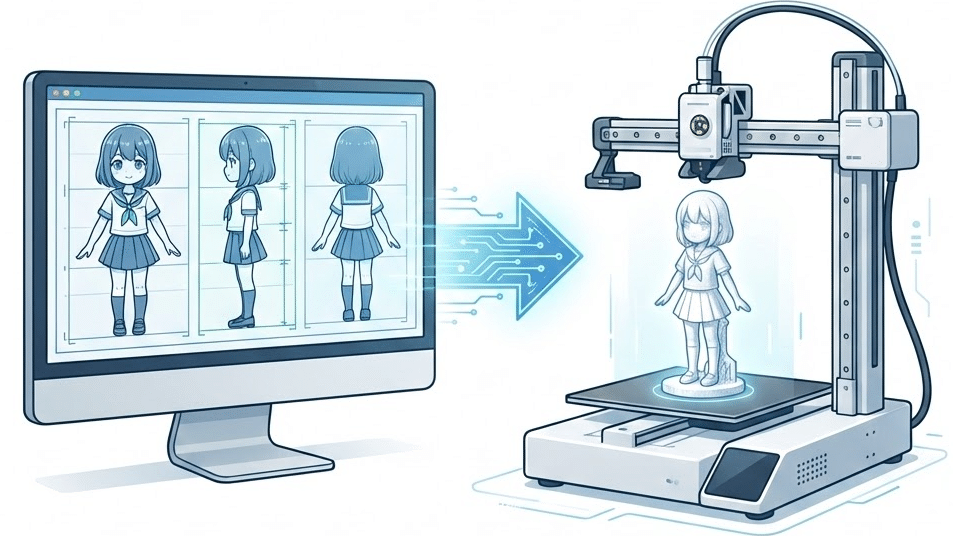

もう一つの選択肢:写真からAIで生成する(Tripo AI)

「スキャンがうまくいかないなら、AIに作ってもらえばいいじゃない」

実はこれも試してみたんですよ。僕の娘の写真を使って、「Tripo AI(トリポAI)」 というサービスで生成してみました。

ただ、写真をそのまま突っ込むんじゃなくて、ちょっとした裏技を使ったんです。これが凄かった。

【まー流:AIフィギュア化ワークフロー】

- ChatGPTやGeminiにお願いする

まず、娘の写真をアップロードして、「この写真をフィギュア化してください」「フィギュアの正面画像を作ってください」と指示します。これであえてイラスト調(デフォルメ)にしちゃうんです。 - 4面図を作らせる

出来上がった正面画像を見せて、「このフィギュアの右側面の画像を作ってください」「次は後ろ側面の画像を…」と、一面ずつ生成してもらいます。こうすると、矛盾の少ない4面図(正面・右・左・後ろ)が手に入ります。 - Tripo AIに食わせる

この4枚の画像をTripo AIにアップロードして、STLデータ化します。

この手順でやると、スキャン特有のノイズが一切ない、めちゃくちゃきれいなデータが出来るんです!

最初からAIが「フィギュアとして成立する形」を描いてくれているので、A1 mini(FDM)で出力しても破綻しないし、デフォルメ感が逆に可愛くて「これこれ!こういうのが欲しかったんだよ」ってなるんですよね 😊

4面の写真から高精度なモデルを作る機能は課金が必要な場合もありますが、自分でスキャンして「溶けた顔」を量産するより、よっぽど精神衛生上いいかもしれません。

どうしても立体で欲しいなら、この「生成AI × 生成AI」のコンボ技、ぜひ試してみてください。

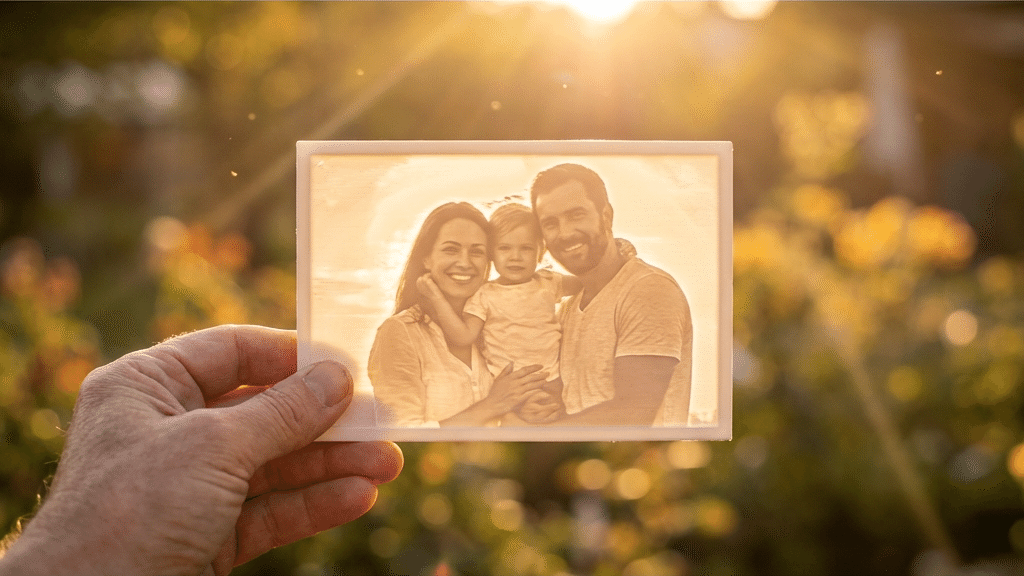

究極の逃げ道:リソファン

正直、人の顔を3Dプリントで「似てる」と思わせるのはかなり難しいです。

でも 「リソファン(Lithophane)」 という手法なら、ほぼ確実に成功します。

これは写真を薄い板状に出力して、光を透かして見るもの。厚い部分は暗く、薄い部分は明るく見えるから、写真のように見えるんです。

3Dスキャンの失敗要素(形状の歪み、色の喪失)を全部回避できるから、家族写真とかをリソファンにするのはおすすめですよ ✨

まとめ

今回の検証で分かったのは、テクノロジーには得意・不得意があるということ。

LiDARは部屋のスキャンには向いてるけど、顔の細部にはちょっと粗いかもしれない。スマホの3Dスキャンは手軽だけど、髪や目という「人間らしさ」の象徴については、まだ工夫が必要。

でもね、失敗もまたDIYの楽しみだと思うんです 😊

僕のリビングには今も「呪物」が鎮座してますが、これはこれで話のネタになるし、「次はもっとうまくやろう」というモチベーションにもなってます。

次回はリソファンでリベンジする予定です。今度こそ家族に「いいね!」と言ってもらえる作品を作りたいな。

この記事の内容はYouTube動画やPodcastでも解説しています。(ながら聞きしたい方はこちら!)

コメント