みなさん、こんにちは!👋

前回の第5章では、AIの正体が「巨大なサイコロを振るマシン」であり、その「温度」を変えることで、真面目な優等生にも、自由なアーティストにもなれるというお話をしました🎲

「なるほど、AIは言葉の確率を計算するプロなんだね!」

そう納得していただけたかと思います。

でも……ちょっと待ってください✋

2025年11月、AIの世界にまたしてもとんでもない革命が起きたのをご存知でしょうか?

Googleは「Gemini 3.0」を、OpenAIは「ChatGPT 5.1(GPT-5.1)」を相次いでリリースしました🚀

これらの最新AIは、もう「言葉」だけではありません。

冷蔵庫の中身の写真を撮って「これで何が作れる?」と聞けばレシピを教えてくれるのは当たり前。

会議の動画を見せれば「あ、このあたりから議論が少し白熱していますね」といった、雰囲気の変化まである程度読み取れるようになってきているんです😲

これって、すごく不思議だと思いませんか?

だって、AIは「0」と「1」しか分からない計算機のはず。

彼らは一体どうやって、「赤いリンゴ」の色や、「白熱した議論」のニュアンスを理解しているのでしょうか?🤔

実は、AIは「ある乱暴な方法」を使って、無理やり画像を「言葉」として読んでいるのです!

今日は、AIに「目」と「耳」を授けた魔法の技術、「マルチモーダル」の秘密を解き明かしていきます。

これを読むと、明日から写真を撮るのが少し楽しくなるかもしれませんよ✨

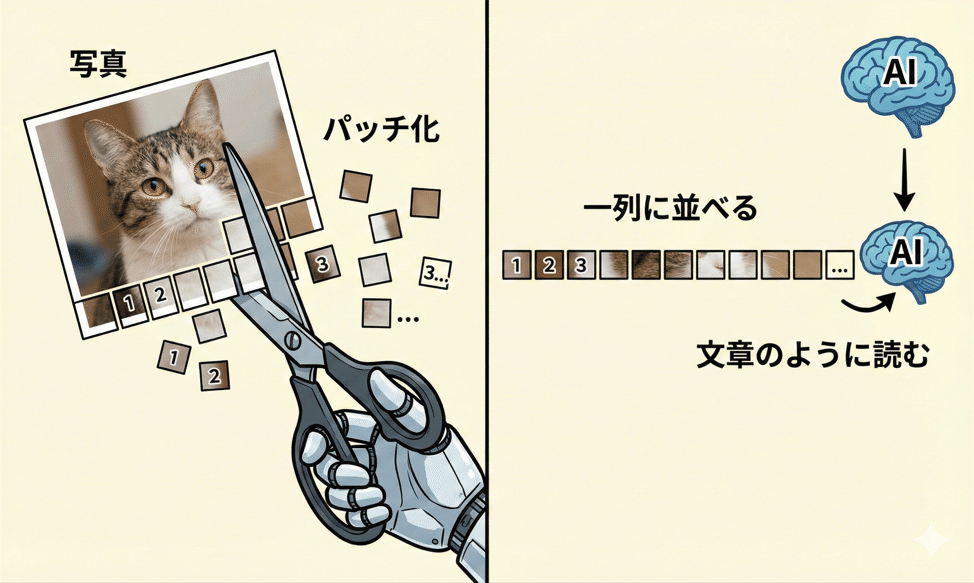

1. 画像をどうやって読む? 秘密は「パッチ化」 🧩

AIは人間のように、風景を「きれいだな〜」と眺めているわけではありません。

彼らが画像を理解するために行っている処理。

それが「パッチ化(Patching)」です!

ちょっと衝撃的かもしれませんが、AIは写真を読み込むとき、頭の中でハサミを使って写真をジョキジョキと切り刻んでいるのです✂️

イメージしてみてください。

ここに一枚の「猫の写真」があります。

AIはこれを、例えば「16×16ピクセル」くらいの小さな正方形(パッチ)に、縦横まっすぐに切り分けます。

まるで、ジグソーパズルのピースや、お風呂のタイルのようにバラバラにするんです。

そして、ここからがポイント!

AIは、切り刻んだそのピースを、一列にズラッと並べます。

・1番目のピース:「左上の背景の青空」

・2番目のピース:「猫の耳の先っぽ」

・3番目のピース:「猫のひげの一部」

・……

・最後(100番目)のピース:「右下の地面」

こうして一列に並べると、あら不思議。

これって、第2章で解説した「単語が一列に並んだ文章(トークン)」と、構造がそっくりじゃありませんか?😲

そうなんです!

AI(Vision Transformerなどの技術)は、画像をバラバラのピースに分解して一列に並べることで、「画像を長い文章として読んでいる」のです!📖

「この『耳のピース』の隣には『顔のピース』があるはずだ……」というふうに、言葉と同じように文脈を読んでいるんですね。

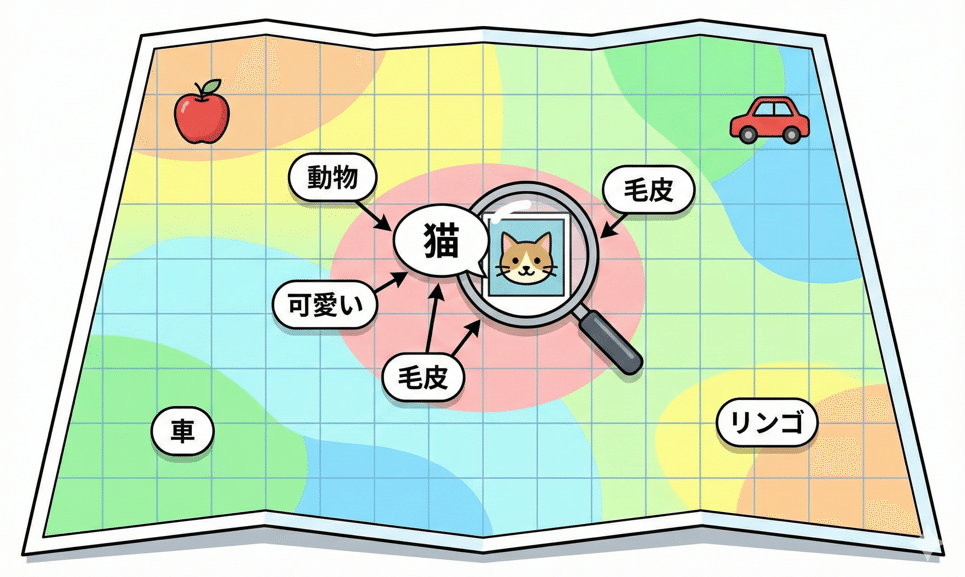

2. 「言葉」と「画像」が出会う場所 〜意味の地図・再訪〜 🗺️

「画像をパズルにして読むのはわかった。でも、どうして『これは猫だ』って意味がわかるの?」

鋭い質問です!✨

ここで思い出してほしいのが、第2章で登場した「意味の地図(座標)」です。

「王様」の近くに「女王」がいて、「リンゴ」は遠くにある……あの地図のことです🗺️

実は、AIの頭の中では、言葉も画像も、この「同じ地図」の上に配置されています。

AIは何兆枚もの「猫の画像」と、それにつけられた「猫(Cat)」というラベルをセットで学習しています。

その結果、地図上で不思議なことが起こります。

・言葉の「猫」がいる座標📍

・パッチ化された「猫の画像データ」がいる座標📍

この2つが、地図上でピタッと重なる(あるいは非常に近くなる)ように調整されるのです!🤝

だからAIにとっては、

「Cat」という文字を見るのも、

「猫の写真」を見るのも、

数学的には「地図上の同じ場所を見ている」ことになります。

「この写真について説明して」と言われたら、AIは地図上でその写真のデータの近くにある単語(「猫」「可愛い」「毛皮」「動物」など)を拾ってくればいいわけです。

これが、AIが写真を見てお喋りできるカラクリなんです!

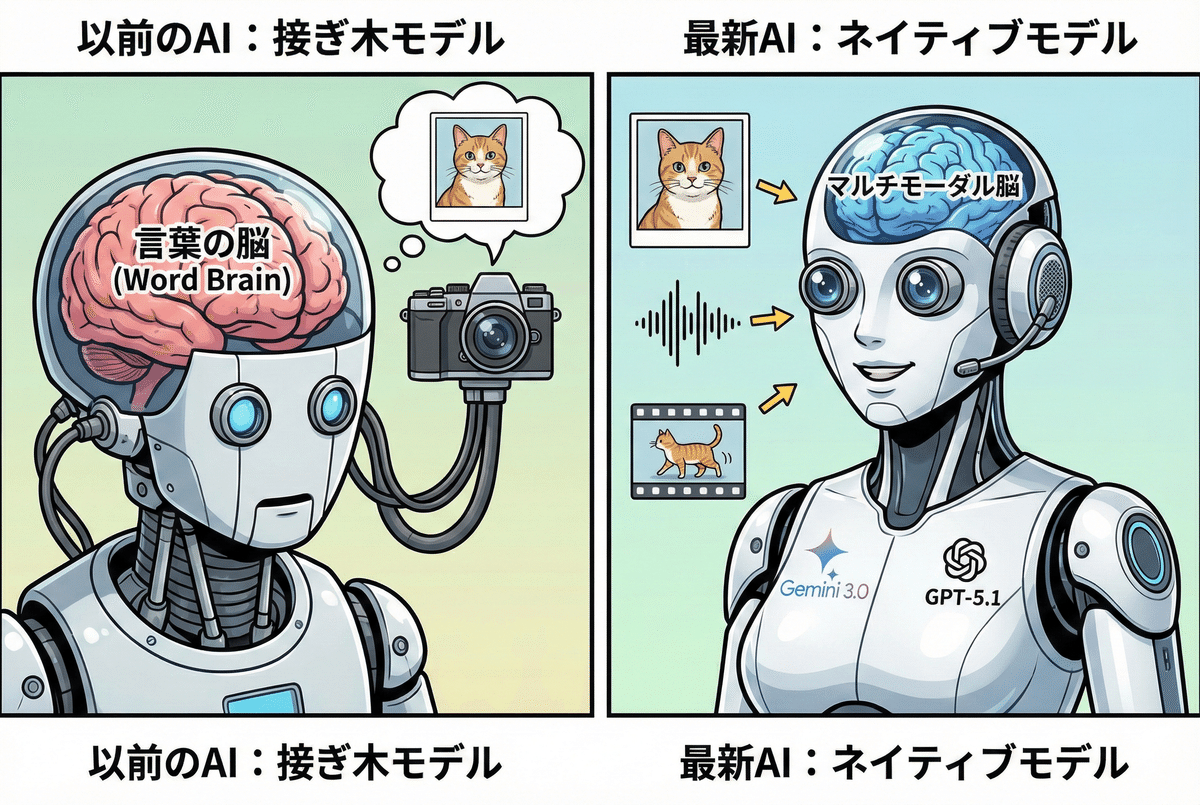

3. 「後付けの目」から「生まれつきの目」へ 〜ネイティブ・マルチモーダル〜 👶

さて、この「目を持ったAI」ですが、実はここ数年で劇的な進化を遂げました。

最新の「Gemini 3.0」や「GPT-5.1」がなぜ凄いのか、その理由がここにあります。

以前のAI:接ぎ木(つぎき)モデル 🌳

少し前のAI(GPT-4の初期版など)は、このタイプが多かったと言われています。

もともとあった「言葉専用の超賢い脳みそ」に、後付けで「視覚センサー(カメラ)」をケーブルで繋いだような状態です。

この場合、「画像専用の頭」でいったん特徴を取り出し、それを「言葉の頭」に渡すという二段構えの処理を行っていました。

いわば、「通訳」を通している状態です。

これだと、「猫の毛並みのフワフワ感」や「夕暮れの切ない雰囲気」といった、言葉にしにくい微妙なニュアンスが抜け落ちてしまうことがありました💦

最新AI(2025年版):完全なネイティブ・マルチモーダル 🦸♂️

これに対し、2025年11月に登場したGemini 3.0やGPT-5.1は、「ネイティブ」と呼ばれています。

これは、生まれたとき(事前学習の段階)から、テキスト・画像・音声・動画が全部混ざった教科書で勉強してきたエリートです。

彼らには「通訳」が必要ありません。

画像は画像のまま、音声は音声のまま、ダイレクトに脳みそで理解できます。

だからこそ、「動画の中で、議論が白熱した瞬間」といった、言葉では表現しきれない空気感や流れまで読み取ることができるのです!

GPT-5.1では、より人間らしく自然な対話ができるようになり、こちらの意図に寄り添った反応をしてくれるようになりました。

Gemini 3.0では、動画の内容を深く理解し、「次にどうすべきか」を考える推論能力が劇的に向上しています。

これが「ネイティブ」の凄さなんですね🚀

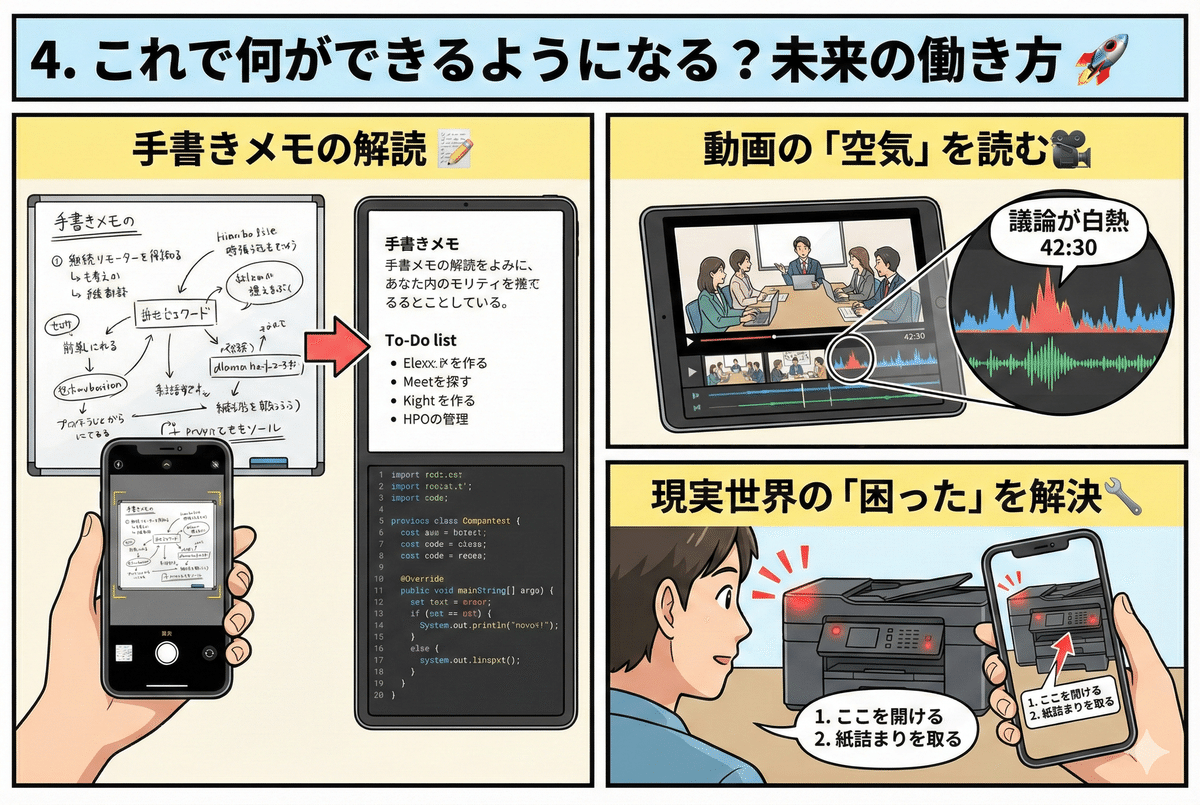

4. これで何ができるようになる? 未来の働き方 🚀

AIが「目」と「耳」をネイティブに使いこなすことで、私たちの生活や仕事はどう変わるのでしょうか?

SF映画のような未来が、もうすぐそこまで来ています!

・ホワイトボードがそのまま議事録に!📝

会議で汚い字で書いたホワイトボードの図やメモ。これをスマホで撮るだけで、AIが完璧なテキストの議事録にまとめたり、そこからToDoリストを作ったり、プログラミングのコードに変換したりしてくれます。手入力の時間はもうゼロです!

・動画の「空気」を読む!🎥

「昨日の1時間の会議動画の中で、議論が盛り上がったポイントはどこ?」

そんな時も、Gemini 3.0に動画を渡せば、音声のトーンや発言頻度の変化を読み取って、「42分30秒あたりから活発な議論が行われています」と教えてくれます。

・現実世界の「困った」を解決!🔧

故障したプリンターの前に立ち尽くしたことはありませんか?

これからは、スマホのカメラをかざして「どうやって直すの?」と聞くだけでOK。GPT-5.1がランプの点滅パターンやエラーコードを見て、「ここを開けて、紙詰まりを取ってください」と優しく教えてくれるようになります。

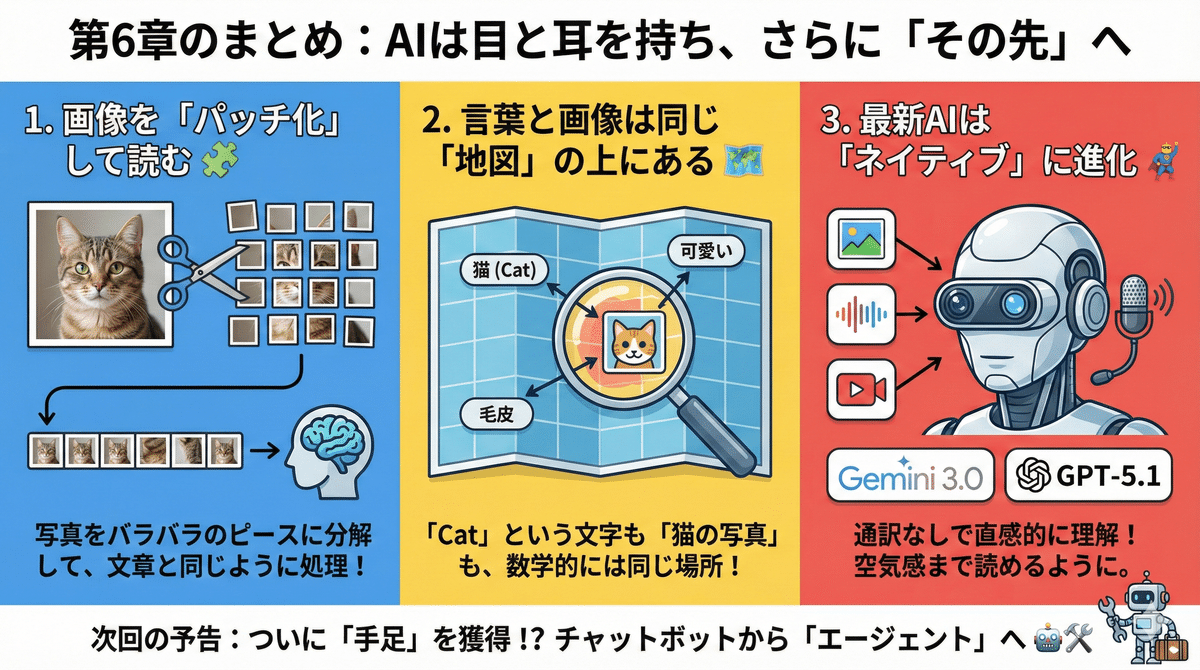

まとめ:AIは目と耳を持ち、さらに「その先」へ 👋

第6章のポイントをまとめておきましょう📝

1.AIは画像を「パッチ(小さなタイル)」に切り刻んで、文章と同じように読んでいる✂️

2.言葉も画像も、「同じ意味の地図」の上にあるから、相互に翻訳できる🗺️

3.最新のGemini 3.0やGPT-5.1は、「ネイティブ」に進化し、言葉にできない空気感まで理解し始めた🦸♂️

AIはもう、画面の中にある「文字だけの辞書」ではありません。

私たちと同じように世界を見て、音を聞いて、それを理解できる「目と耳を持ったパートナー」へと進化しているのです✨

さて、脳(テキスト)を持ち、感覚(目と耳)も持ったAI。

かなり人間に近づいてきましたね。

でも……今のAIには、まだ決定的に足りないものがあります。

それは、「手足」です。

画面の中でアドバイスはくれるけれど、実際に私たちの代わりにホテルを予約したり、メールを送信したりといった「行動」までは、まだ完全には任せられませんよね?

次回、第7章では、ついにAIが画面を飛び出し、自律的に行動を開始する未来、

「エージェントAI」について解説します。

一部ではすでに始まっている「ブラウザの自動操作」や「メールの下書き作成」など、AIが本当の意味で「手足」を持ち始めた最前線に迫ります!

(次回予告)

第7章:チャットボットから「エージェント」へ ― 自律するAI

〜「旅行の計画」から「予約」まで、全部勝手にやってくれる未来〜

お楽しみに!👋

コメント