みなさん、こんにちは!👋

前回の第2章では、AIが言葉を「意味の地図(座標)」として捉えているというお話をしました。

「王様 - 男 + 女 = 女王」

この計算式の謎が解けたとき、AIが少しだけ身近に感じられたのではないでしょうか?🗺️

「よし、言葉の意味がわかるなら、もうAIは完璧だね!」

……と言いたいところですが、実は2017年頃までのAIには、ある致命的な弱点がありました。

それは、「ひどい健忘症(記憶喪失)」だったことです😱

単語の意味はわかる。でも、長い会話ができない。

今日は、そんなポンコツだったAIが、いかにして「文脈を読む天才」へと進化したのか。

現在のAIブームの立役者であり、最強の脳みそと呼ばれる技術「Transformer(トランスフォーマー)」の秘密に迫ります!🚀

1. 地図を持っていても「迷子」になる理由 😵

少しだけおさらいです。

昔のAIも、前章で解説した「単語の辞書(地図)」は持っていました。

しかし、彼らは文章を読むのが絶望的に下手だったのです。

なぜなら、昔のAI(RNNなどと呼ばれます)は、「文章を前から順番に、一文字ずつしか読めなかった」からです。

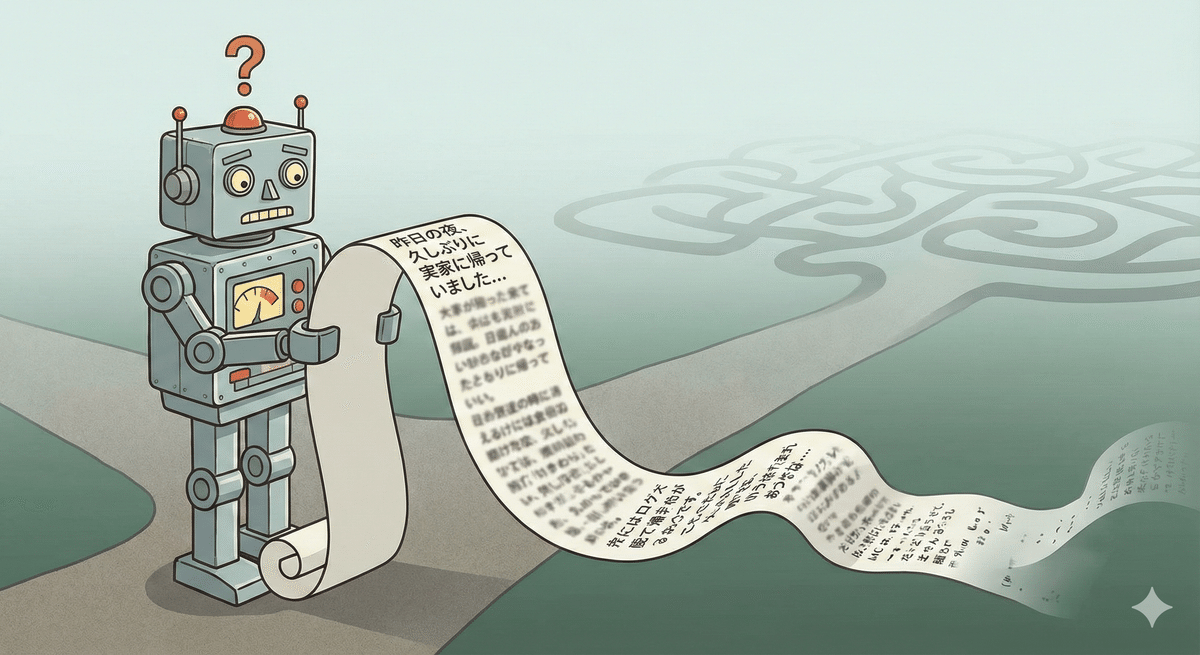

想像してみてください。

あなたが誰かから、とても長い相談を受けているとします。

「昨日の夜、久しぶりに実家に帰って、昔飼っていた犬の写真を見つけたんだけど、その写真の裏に……(中略)……でね、それがすごく懐かしかったんだ」

この話を聞いて、「それ」が指すものは何かわかりますか?

そう、「犬の写真」ですよね🐶

でも、昔のAIはこうなってしまいます。

「『それ』……? ええと、直前に『写真の裏』って言ったから、裏のことかな? あれ、そもそも何の話だっけ? 実家? 犬? ……ダメだ、最初のほうの話、もう忘れちゃった!😭」

これを「伝言ゲーム」に例えるとわかりやすいかもしれません。

長い列を作って、端から端へ耳打ちで情報を伝えていくと、最後の人に届く頃には、最初とは全然違う内容になってしまいますよね?

これと同じで、文章が長くなればなるほど、前の文脈(コンテキスト)を忘れてしまう「破滅的忘却」という課題があったのです。

「単語の意味はわかるけど、文脈がつながらない」

これが、少し前のAIの限界でした。

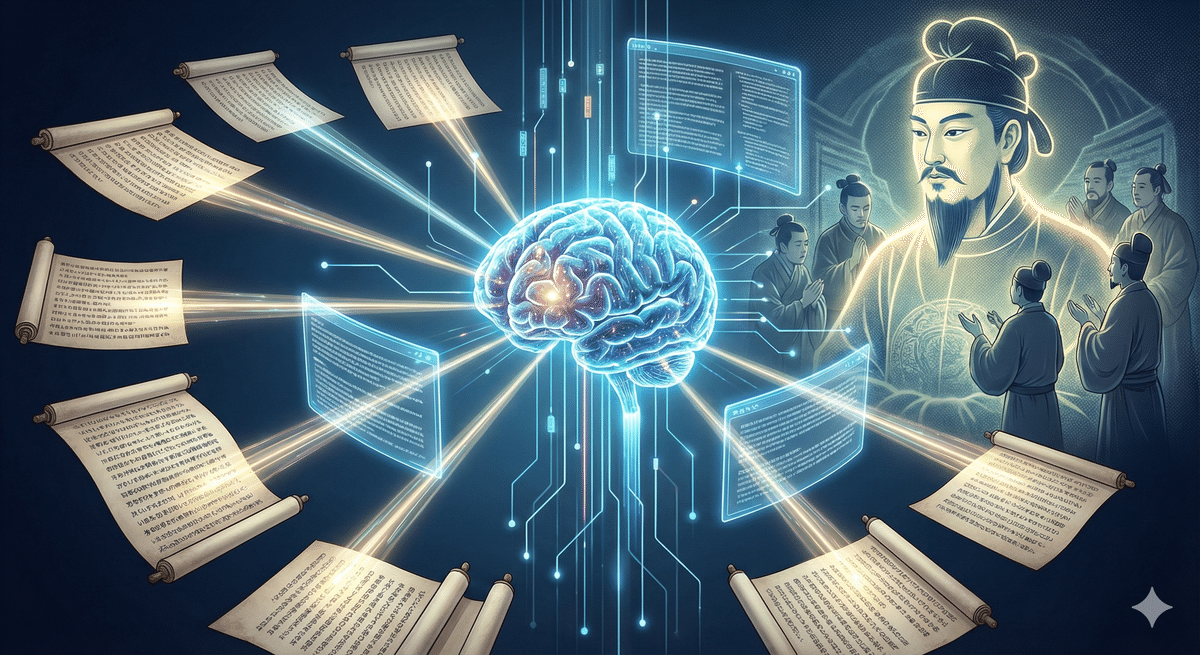

2. 革命的進化:「聖徳太子」のような読み方 📜

そんな停滞していたAI業界に、2017年、激震が走ります。

Googleの研究チームが発表した論文『Attention Is All You Need(必要なのは「注目」だけ)』です。

ここで提案された「Transformer」という仕組みは、今までの常識を覆すものでした。

「前から順に読むのなんて、もうやめよう。全部まとめて、一気に見ればいいじゃないか!」

そう、Transformerは、文章の最初から最後までを、まるで一枚の絵画を見るように「同時(並列)」に処理するのです。

例えるなら、「オーケストラの指揮者」です🎶

指揮者は、バイオリンだけ、フルートだけを順番に見るわけではありません。

全体を同時に見渡しながら、「今はここが重要」「あそことあそこが呼応している」と全体像を把握します。

あるいは、一度に何人もの話を聞き分けたという「聖徳太子」をイメージしてもいいかもしれません👂

文章全体を「せーの!」で一気に読み込むことで、最初に出てきた単語と、最後に出てきた単語の関係性を、距離に関係なく一瞬で計算できるようになったのです。

これにより、AIの計算効率と理解力は飛躍的に向上しました。

3. 魔法のスポットライト:「Attention(注意)機構」の正体 🔦

「でも、全部を一気に読んだら、情報量が多すぎて混乱しないの?」

いい質問です!✨

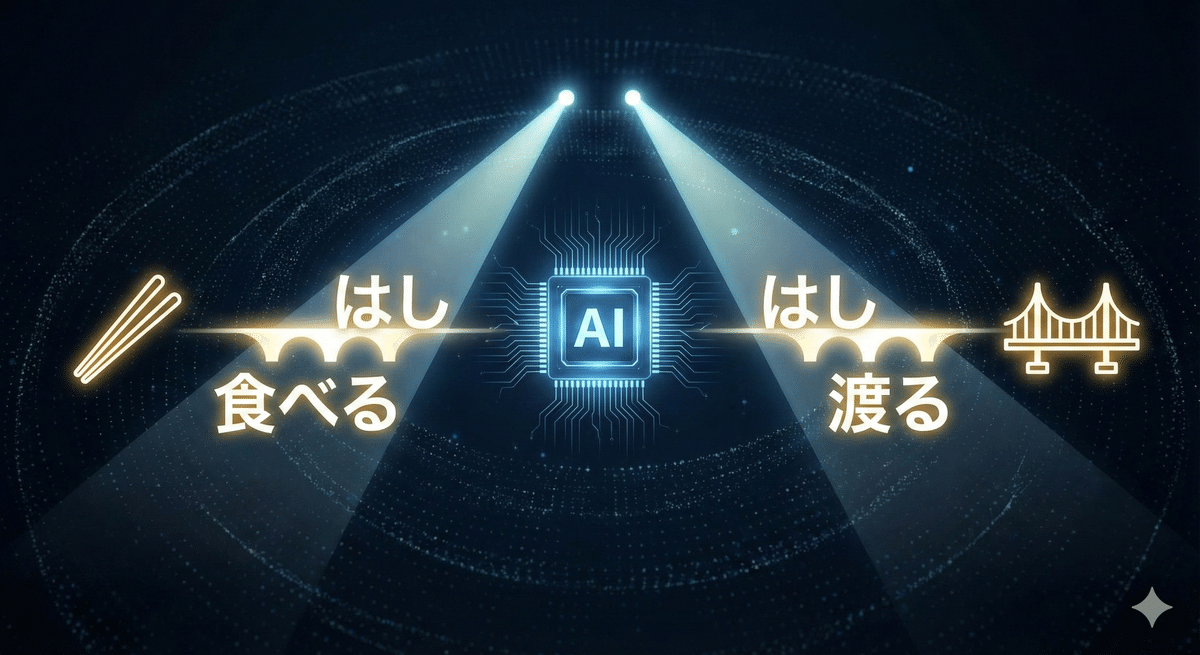

そこで登場するのが、Transformerの心臓部であり、今回の主役「Self-Attention(自己注意機構)」です。

これは、文章の中の「どの単語とどの単語が結びついているか」を見つけ出す機能です。

わかりやすく、「真っ暗な舞台のスポットライト」で考えてみましょう🎭

舞台(文章全体)は暗闇です。

そこに、ある単語、例えば「バンク(Bank)」という役者が登場し、スポットライトが当たります。

英語の「Bank」には、「銀行」という意味と、「川の土手」という意味がありますよね。これだけではどちらかわかりません。

そこでAIは、「バンク」にライトを当てたまま、自動的にもう一つのライトを別の単語に向けます(ここが重要!)。

・パターンA:

もし、もう一つのライトが「お金」や「預ける」という単語を照らしたら……?

AIは瞬時に理解します。「あ、今回のバンクは『金融機関』の方だ!」🏦

・パターンB:

もし、もう一つのライトが「川」や「釣り」という単語を照らしたら……?

AIは判断します。「なるほど、今回のバンクは『土手』のことだな!」🏞️

日本語でも同じです。

「はしで食べる」という文章があったとき、「食べる」という単語にライトが当たれば、AIは「この『はし』は『箸』のことだ🥢」と判断できます。

「はしを渡る」なら、「渡る」にライトが当たるので「橋」だとわかります🌉

このように、AIは文章中のすべての単語に対して、

「今の文脈だと、自分は誰と仲良くすべき?」

「この言葉の意味を決定づけるヒントはどこにある?」

という確認(照合)を、猛烈なスピードで行っているのです。

これが、AIが「文脈」を理解できるカラクリです。

数千文字前の伏線だって、このスポットライト(Attention)があれば、一瞬で回収できてしまうのです!💡

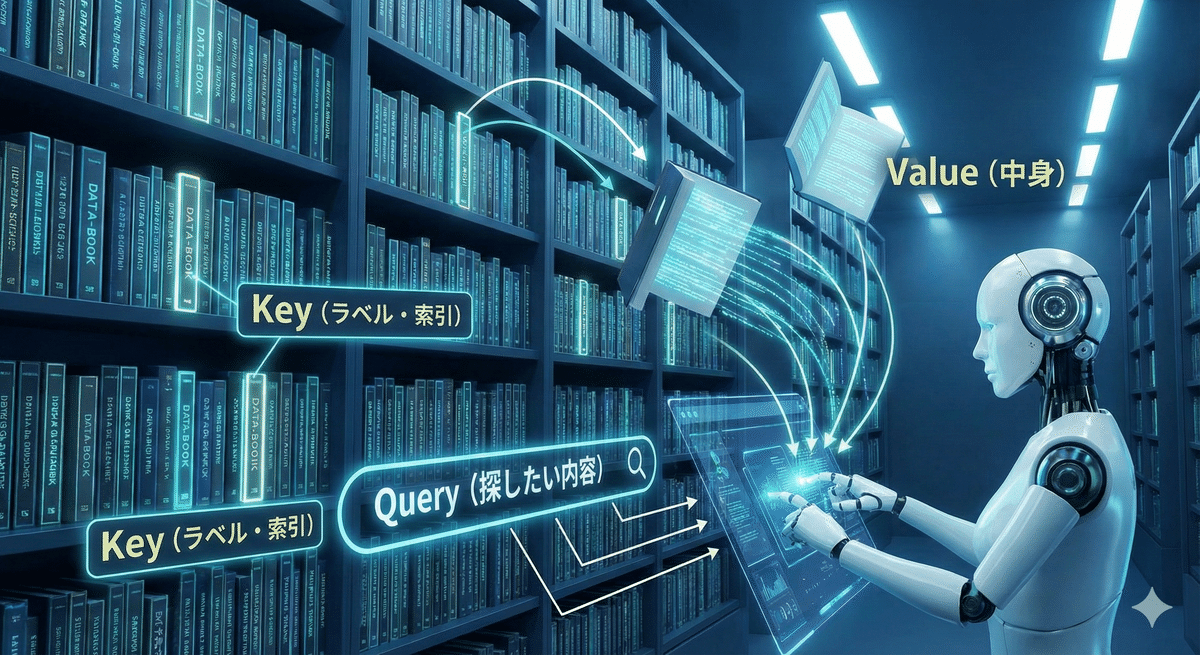

4. 図書館の検索システム:「Query・Key・Value」 📚

さて、ここからは少しマニアックですが、知っておくと「おっ、詳しいね」と言われる仕組みのお話です(読み飛ばしても大丈夫ですよ!)。

この「スポットライトをどこに当てるか」を決める裏側では、実は「図書館の検索」のような処理が行われています。

専門用語で「Query(クエリ)」「Key(キー)」「Value(バリュー)」の3つの要素を使います。

1.Query(クエリ):探したい内容

「私は何に注目すべきですか?」という問いかけ。図書館での「検索ワード」です🔍

2.Key(キー):ラベル・索引

「私はこういう内容の単語ですよ」という自己主張。本の「背表紙」や「タグ」です🏷️

3.Value(バリュー):中身

実際の単語の意味情報。本の「中身」そのものです📖

AIは、文章中のある単語(Query)に対して、他のすべての単語のラベル(Key)をチェックします。

「私の検索ワードと、あなたのラベル、相性はどう?」

そして、相性(関連度)が高い単語だけを選んで、その中身(Value)を情報として取り込みます。

「図書館で、検索機にキーワードを入れて、ヒットした本の中身だけを読んで知識を補強する」

これを、1つの文章を生成する間に何千回、何万回と繰り返しているのが、今のAI(Transformer)なのです🤖📚

まとめ:GPTの「T」はTransformerの「T」 🎓

第3章のポイントをまとめておきましょう📝

昔のAIは記憶喪失:前から順に読んでいたので、長い文章を覚えるのが苦手だった(伝言ゲームの失敗)😫

Transformerの革命:文章全体を「同時に」見ることで、離れた言葉の関係性も一瞬で把握できるようになった(聖徳太子スタイル)📜

Attention(注目):重要な単語同士に「スポットライト」を当てることで、文脈やニュアンスを正確に理解する(文脈の解読)🔦

現在、世界を席巻している「ChatGPT」。

この最後の「T」は、実は今日解説した「Transformer」のTなんです。

つまり、今の生成AIブームは、この「全体を同時に見て、重要なことだけに注目する」という技術の発明によって支えられているのです✨

さて、最強の脳みそを手に入れたAI。

言葉の意味(地図)も持ち、文脈を読む力(スポットライト)も手に入れました。

しかし……生まれたばかりのAIは、まだ何も知らない「空っぽの天才」です。

知識もなければ、善悪の判断もつきません。

ここからどうやって、私たちが使っているような「物知りで、礼儀正しいAI」に育っていくのでしょうか?

次回、第4章では、AIが受ける「過酷なスパルタ教育」の全貌に迫ります。

ネットの海を漂う「ガリ勉」時代から、人間にしつけられる「アメとムチ」の訓練まで……。

AIの知られざる「学校生活」を覗きに行きましょう!🏫

(次回予告)

第4章:AIの学校生活 ― 賢くなるまでの3ステップ

〜図書館への監禁と、アメとムチのしつけ教室〜

お楽しみに!👋

コメント